Bạn có biết rằng mỗi lượt truy cập, mỗi con bot Google và mỗi tương tác trên website của bạn đều để lại dấu vết? Những “dấu vết” đó được lưu lại trong log file nguồn dữ liệu quý giá phản ánh cách công cụ tìm kiếm và người dùng thực sự tương tác với website.

Log File Analysis (phân tích tập nhật ký) chính là quá trình giải mã những dữ liệu này, giúp bạn hiểu rõ Googlebot crawl website ra sao, trang nào được ưu tiên lập chỉ mục và đâu là điểm nghẽn khiến SEO chưa đạt hiệu quả tối đa.

Trong bài viết này, chúng ta sẽ cùng tìm hiểu chi tiết Log File Analysis là gì, tại sao nó quan trọng trong SEO và cách doanh nghiệp có thể ứng dụng để tối ưu hiệu suất website.

1. Tổng quan Log File Analysis là gì?

Mỗi khi một người dùng hoặc công cụ tìm kiếm (như Googlebot) truy cập vào website của bạn, máy chủ (server) sẽ ghi lại toàn bộ hoạt động này dưới dạng log file. Có thể hiểu đơn giản, log file giống như “nhật ký hoạt động” của website, trong đó chứa thông tin chi tiết về mọi lượt truy cập từ con người đến các bot.

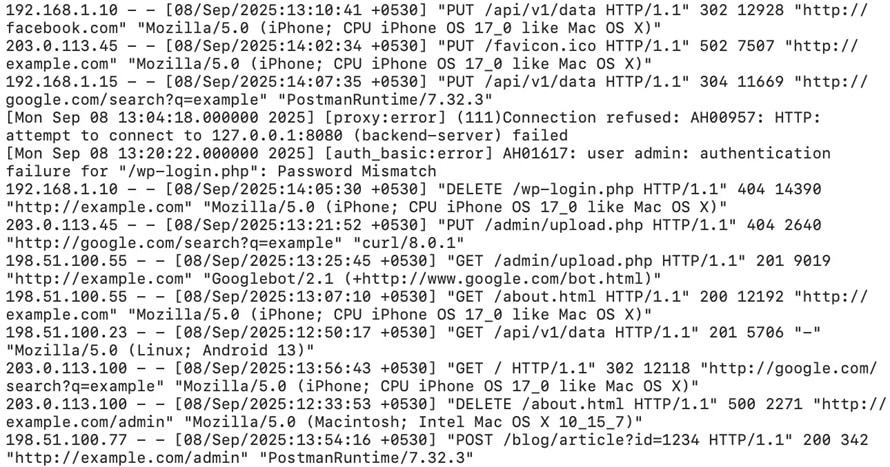

Ví dụ về Log Files

Log File Analysis (phân tích tệp nhật ký) chính là quá trình đọc, phân tích và khai thác dữ liệu từ các file log này. Đối với SEO, đây là một công việc cực kỳ hiệu quả bởi nó cho phép bạn:

- Biết được Googlebot có thực sự crawl website của bạn hay không.

- Xác định trang nào được ưu tiên crawl nhiều, trang nào bị bỏ qua.

- Tìm ra các vấn đề kỹ thuật như lỗi 404, redirect chains, hay server error.

- Đánh giá xem crawl budget của Google có đang được sử dụng hiệu quả hay bị lãng phí.

Trong khi Google Search Console (GSC) chỉ cung cấp một phần dữ liệu giới hạn về “Coverage” và “Crawl Stats”, thì log file analysis lại mang đến dữ liệu thô, trực tiếp từ server, giúp bạn thấy bức tranh toàn diện hơn về cách Googlebot và người dùng thực sự tương tác với website.

Chính vì vậy, log file analysis đã trở thành một phần quan trọng trong SEO kỹ thuật (SEO Technical), đặc biệt đối với các website lớn, website thương mại điện tử có hàng chục nghìn URL, hoặc những website cần tối ưu tốc độ index nội dung.

2. Log File chứa những thông tin gì?

Một log file có thể trông như một chuỗi ký tự khó hiểu, nhưng nếu phân tích đúng cách, bạn sẽ nhận ra nó chứa thông tin dữ liệu phục vụ cho SEO. Dưới đây là những thông tin quan trọng thường xuất hiện trong log file:

Địa chỉ IP (IP Address)

- Xác định nguồn truy cập là từ đâu.

- Có thể phân biệt được truy cập từ bot, người dùng thật hay bot giả mạo.

- Cho biết trình duyệt hoặc bot nào đang truy cập website.

- Ví dụ: Googlebot, Bingbot, AhrefsBot, Chrome, Safari…

- Đây là yếu tố quan trọng để phân biệt lượt crawl của Googlebot và lượt truy cập của người dùng.

Thời gian truy cập (Timestamp)

- Mỗi log đều có dấu thời gian chính xác đến giây.

- Giúp bạn biết khi nào Googlebot crawl website và tần suất truy cập.

URL được truy cập

- Ghi rõ đường dẫn (path) của trang mà bot hoặc người dùng đã vào.

- Nhờ đó bạn biết trang nào được Googlebot quan tâm nhiều nhất, trang nào không hề được crawl.

Mã trạng thái HTTP (Status Code)

Các mã phổ biến gồm:

- 200 (OK): Trang hoạt động bình thường.

- 301 / 302 (Redirect): Trang chuyển hướng.

- 404 (Not Found): Trang bị lỗi, không tồn tại.

- 500 (Server Error): Lỗi phía server.

Việc phân tích status code giúp bạn phát hiện và xử lý lỗi nhanh chóng, tránh mất crawl budget.

Kích thước dữ liệu phản hồi (Response Size)

- Cho biết dung lượng của trang được trả về.

- Trang quá nặng có thể ảnh hưởng đến tốc độ crawl.

Phương thức HTTP (Method: GET/POST/HEAD)

- GET: truy xuất nội dung.

- POST: gửi dữ liệu (form, đăng nhập…).

- HEAD: kiểm tra header mà không tải nội dung.

- SEO chủ yếu quan tâm đến GET, bởi đó là phương thức Googlebot dùng để lấy nội dung.

Như vậy, chỉ từ một log file, bạn đã có thể nắm rõ: Ai đang truy cập website của mình, khi nào, vào đâu và kết quả thế nào. Đây chính là dữ liệu nền tảng để các SEOer tối ưu khả năng crawl, index và cải thiện hiệu suất website trên Google.

3. Log File Analysis được sử dụng để làm gì trong SEO?

Trong SEO, việc hiểu rõ cách Googlebot và các công cụ tìm kiếm crawl (thu thập dữ liệu) website là yếu tố then chốt để đảm bảo nội dung quan trọng được index nhanh chóng, hiệu quả. Và log file chính là công cụ giúp bạn nhìn thẳng vào những hoạt động crawl thực tế, thay vì chỉ dựa vào suy đoán hoặc dữ liệu gián tiếp từ các công cụ SEO.

Dưới đây là những cách mà Log File Analysis được sử dụng trong SEO:

1. Đánh giá hiệu quả sử dụng Crawl Budget

Google có giới hạn nhất định về số lượng trang mà bot có thể crawl trong một khoảng thời gian (crawl budget).

Với các website lớn (thương mại điện tử, báo chí, rao vặt…), nếu crawl budget bị lãng phí cho các trang lỗi, duplicate hoặc không quan trọng, thì những trang mới, trang sản phẩm hoặc bài viết giá trị có thể bị bỏ sót.

Vì thế việc phân tích log file giúp bạn:

- Biết Googlebot đang tiêu tốn crawl budget ở đâu.

- Tối ưu lại cấu trúc, internal link và robots.txt để phân bổ crawl hợp lý.

2. Hiểu rõ trang nào được Google ưu tiên

Log file cho bạn thấy URL nào được crawl nhiều nhất và URL nào ít được chú ý.

Nếu các trang quan trọng (trang sản phẩm chính, landing page, danh mục) ít được crawl, đó là tín hiệu bạn cần tối ưu lại cấu trúc site hoặc internal linking.

3. Phát hiện và xử lý lỗi kỹ thuật kịp thời

Log file liệt kê rõ mã trạng thái (200, 301, 404, 500…).

Nhờ đó bạn có thể:

- Nhanh chóng phát hiện 404 errors (trang hỏng, link gãy).

- Xác định redirect chain (chuyển hướng lòng vòng làm lãng phí crawl budget).

- Theo dõi lỗi server (5xx) gây cản trở Googlebot truy cập.

Đây là những lỗi mà Google Search Console thường báo chậm hoặc chưa đầy đủ.

4. Kiểm chứng lại dữ liệu từ công cụ SEO

Google Search Console chỉ cung cấp dữ liệu giới hạn trong mục “Crawl Stats”.

Các công cụ SEO khác (Screaming Frog, Ahrefs, Semrush) mô phỏng hành vi crawl, nhưng không thể thay thế dữ liệu thực tế từ server.

Log file analysis chính là cách duy nhất để xác minh Googlebot thực sự làm gì trên website của bạn.

5. Cải thiện tốc độ index & chiến lược SEO nội dung

Khi bạn xuất bản bài viết mới hoặc sản phẩm mới, log file giúp bạn theo dõi:

- Bao lâu thì Googlebot crawl trang mới.

- Trang đó có được index hay bị bỏ qua.

Điều này đặc biệt quan trọng cho các website tin tức, TMĐT, hoặc doanh nghiệp thường xuyên cập nhật nội dung.

6. Tối ưu trải nghiệm người dùng gián tiếp

Một website nhiều lỗi 404, redirect lòng vòng, hoặc tốc độ phản hồi chậm không chỉ ảnh hưởng đến Googlebot mà còn làm giảm trải nghiệm người dùng.

Log file analysis giúp bạn đo lường và cải thiện hiệu suất tổng thể, từ đó hỗ trợ cả SEO lẫn conversion (chuyển đổi).

Nói tóm lại, Log File Analysis là công cụ không thể thiếu trong Technical SEO, giúp doanh nghiệp nắm rõ:

- Googlebot có đang crawl đúng trang không?

- Crawl budget có đang được tối ưu không?

- Website có lỗi kỹ thuật nào ảnh hưởng đến SEO không?

4. Các công cụ và cách thực hiện Log File Analysis trong SEO

Để khai thác tối đa sức mạnh của log file analysis, SEOer cần nắm được:

- Cách lấy log file từ server.

- Công cụ phân tích log file phù hợp với quy mô và mục tiêu SEO.

- Quy trình phân tích để biến dữ liệu thô thành insight thực tế.

1. Cách lấy log file từ server

Log file được lưu trực tiếp trên máy chủ (server) – nơi website của bạn vận hành. Tùy loại hosting hoặc CMS, bạn có thể:

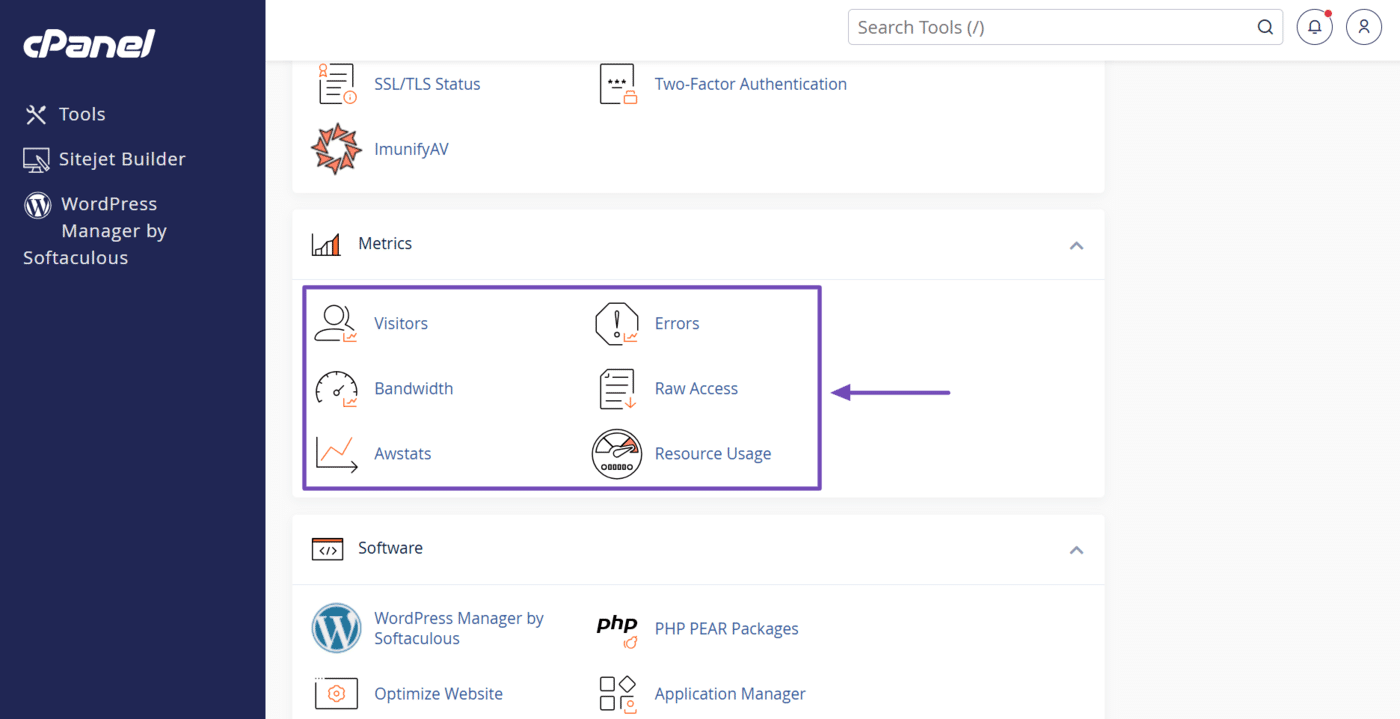

Truy cập qua cPanel / Plesk:

Hầu hết hosting phổ biến đều lưu log file trong mục Raw Access Logs.

Sử dụng SSH hoặc FTP:

Với VPS/Dedicated server, bạn có thể đăng nhập SSH và lấy log từ thư mục /var/log/ (ví dụ: access.log, error.log).

CMS hoặc Plugin hỗ trợ:

Một số plugin WordPress có thể ghi nhận log crawl cơ bản.

Yêu cầu đội IT:

Với doanh nghiệp lớn, bạn có thể cần IT hỗ trợ để trích xuất log định kỳ.

Lưu ý: Log file có thể rất nặng (vài GB mỗi tháng). Nên nén và lưu trữ định kỳ để tiện phân tích.

2. Các công cụ phân tích Log File cho SEO

Công cụ miễn phí & cơ bản

- Excel / Google Sheets: Phù hợp cho website nhỏ (<10.000 URL).

- GoAccess (mã nguồn mở): Phân tích log trực tiếp trên server, hiển thị dạng dashboard.

- Screaming Frog Log File Analyser (phiên bản free giới hạn URL).

Công cụ chuyên nghiệp

- Screaming Frog Log File Analyser (bản trả phí): Cho phép import log file, kết hợp dữ liệu crawl với log để biết Googlebot crawl gì thực sự.

- Botify: Enterprise tool mạnh mẽ, thường dùng cho website TMĐT, báo chí lớn.

- OnCrawl: Tích hợp dữ liệu log file với phân tích SEO onpage, tối ưu crawl budget.

- Semrush Log File Analyzer: Dễ dùng, tích hợp sẵn trong hệ sinh thái Semrush.

Giải pháp custom (IT + SEO)

Kibana + ElasticSearch + Logstash (ELK Stack): Hệ thống phân tích log chuyên nghiệp, phù hợp với doanh nghiệp lớn muốn theo dõi log real-time.

3. Quy trình thực hiện Log File Analysis

Để phân tích log file hiệu quả, bạn có thể đi theo 5 bước sau:

Bước 1: Thu thập log file

- Tải dữ liệu log từ server theo tuần hoặc tháng.

- Lưu file dưới dạng .log hoặc .csv để dễ xử lý.

Bước 2: Lọc dữ liệu liên quan

- Chỉ giữ lại các bot quan trọng: Googlebot, Bingbot.

- Loại bỏ bot giả mạo hoặc spam bot.

Bước 3: Phân tích hành vi crawl

- URL nào được Googlebot crawl nhiều nhất?

- Có bao nhiêu request trả về mã lỗi (404, 500)?

- Có redirect chain hoặc redirect loop không?

- Googlebot có crawl thường xuyên nội dung mới không?

Bước 4: Đánh giá Crawl Budget

- So sánh số lần crawl trang quan trọng vs trang không quan trọng.

- Kiểm tra xem bot có đang “lãng phí” crawl ở filter pages, search result pages nội bộ, hoặc trang trùng lặp không.

Bước 5: Đưa ra hành động tối ưu

- Chặn bot crawl trang không quan trọng bằng robots.txt.

- Cải thiện internal link để dẫn bot đến trang cần index.

- Fix lỗi 404/500, rút gọn redirect chain.

- Nâng cấp tốc độ server để bot crawl hiệu quả hơn.

4. Tips thực hành với Log File Analysis

Tập trung vào hoạt động của bot thu thập thông tin của công cụ tìm kiếm

Hãy chú ý đến các yêu cầu từ các bot thu thập thông tin của công cụ tìm kiếm như Googlebot hoặc Bingbot . Hãy phân tích và xem xét các mẫu thu thập thông tin của chúng để đảm bảo chúng thu thập thông tin website của bạn một cách hiệu quả và có thể truy cập vào các trang chính. Bạn cũng nên đảm bảo chúng không lãng phí ngân sách thu thập thông tin của bạn vào việc thu thập nội dung không liên quan.

Xem lại mã phản hồi HTTP Server của bạn

Quét nhật ký của bạn để tìm mã trạng thái HTTP như 404 Không tìm thấy và 500 Lỗi máy chủ nội bộ, cho biết khách truy cập không thể truy cập nội dung của bạn. Sau khi hoàn tất, hãy xác định các URL gây ra những lỗi này và chuyển hướng chúng đến các URL đang hoạt động .

Sử dụng Công cụ Phân tích Tệp Nhật ký

Mặc dù bạn có thể phân tích tệp nhật ký theo cách thủ công, nhưng bạn sẽ cần các công cụ để phân tích lượng dữ liệu lớn. Tuy nhiên, bạn vẫn có thể cân nhắc sử dụng các công cụ phân tích cho lượng dữ liệu nhỏ hơn vì chúng được tối ưu hóa tốt hơn cho việc trực quan hóa dữ liệu và tạo ra những thông tin chi tiết hữu ích.

So sánh Log File với dữ liệu Google Search Console

Đối chiếu dữ liệu log file của bạn với Google Search Console để xác thực số liệu thống kê thu thập thông tin, xác định sự khác biệt và đảm bảo công cụ tìm kiếm lập chỉ mục website của bạn một cách chính xác và hiệu quả.

Sao lưu thường xuyên các log file của bạn

Server, hosting, control panel và mạng phân phối nội dung (CDN) của bạn có thể xóa dữ liệu nhật ký của bạn theo định kỳ. Để tránh điều đó và đảm bảo bạn vẫn có thể truy cập dữ liệu lịch sử, hãy thiết lập hệ thống để tự động sao lưu log file.

Thường xuyên xem lại các log file của bạn

Thường xuyên xem xét và phân tích log file của bạn. Đặt lịch trình thường xuyên như hàng tháng hoặc hai tháng một lần. Trong những khoảng thời gian này, hãy chú ý đến các lỗi thu thập dữ liệu, lỗi máy chủ và các kiểu lưu lượng truy cập bất thường có thể ảnh hưởng đến SEO và trải nghiệm người dùng của bạn.